作者:郭思、赖文昕

编辑:陈彩娴

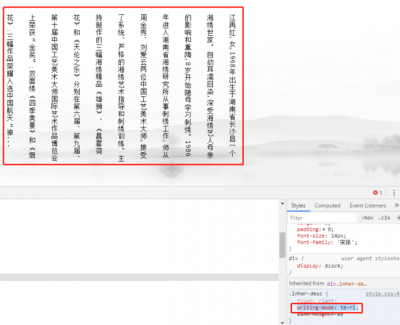

北京时间 3 月 19 日凌晨 4 点,英伟达公司创始人兼 CEO 黄仁勋踏上了美国加州圣何塞 SAP 中心的舞台,开始讲述 2024 GTC 主题演讲《见证 AI 的变革时刻》。

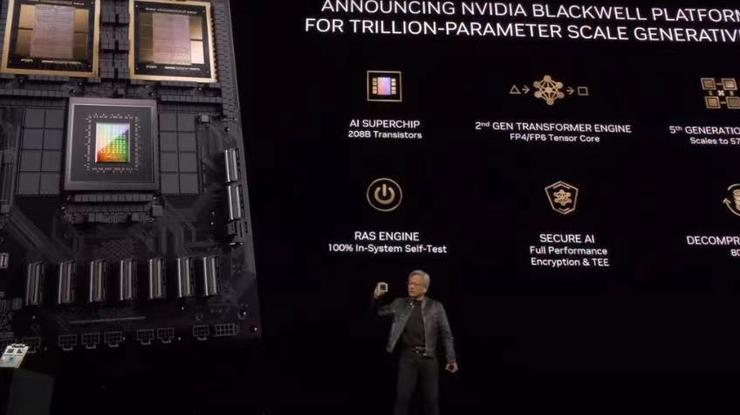

作为“AI 界春晚”中最重要的一项日程,黄仁勋在演讲中揭开了号称“史上最强 AI 芯片 GB200”的神秘面纱,并推出了 NVIDIA Blackwell、NIM 微服务、Omniverse Cloud API 等一系列涵盖硬件、软件开发、云计算的更新。

此外,黄仁勋还官宣了英伟达在机器人和具身智能技术的众多进展,包括了与比亚迪的合作以及运用在人形机器人的基础模型和新型计算机。

英伟达指出,新 Blackwell 架构 GPU 组成的 GB200,将提供 4 倍于 Hopper 的训练性能,大模型参数达到了万亿级别。这意味着同样的计算能力,科技厂商所需的芯片数量会减少。

在目前大模型火爆,商业落地却前景尚不明朗的情况下,GTC 对于整个产业链都来了不同凡响的技术以及商业启发。

史上最强 AI 芯片“GB200”

黄仁勋称,随着 Transformer 模型被发明,大型语言模型以惊人的速度扩展,每六个月就会成倍进步,为了训练这些越来越大的模型,自然也需要更强的算力。

什么是“更强的算力”呢?

黄仁勋从口袋里掏出一块 Blackwell 芯片,将它与 Hopper 芯片并排举起,“我们需要更大的 GPU”。

他宣布英伟达将推出 GB200 系列芯片,将搭载专为处理万亿参数级生成式人工智能而设计的 NVIDIA Blackwell 架构。

新架构继承了两年前推出的 NVIDIA Hopper 架构,以 David Harold Blackwell 命名,这是加州大学伯克利分校专门研究博弈论和统计学的数学家,也是第一位入选美国国家科学院的黑人学者。

同自家产品相比,芯片的性能有了显著的提升。GB200 芯片由两个 Die 封装组合而成,拥有高达 2080 亿个晶体管,采用了台积电 4NP 工艺制程技术,使其能够支持庞大的 AI 模型,参数量可达 10 万亿。相比之下,H100/H200 系列芯片则只配备了 800 亿个晶体管。

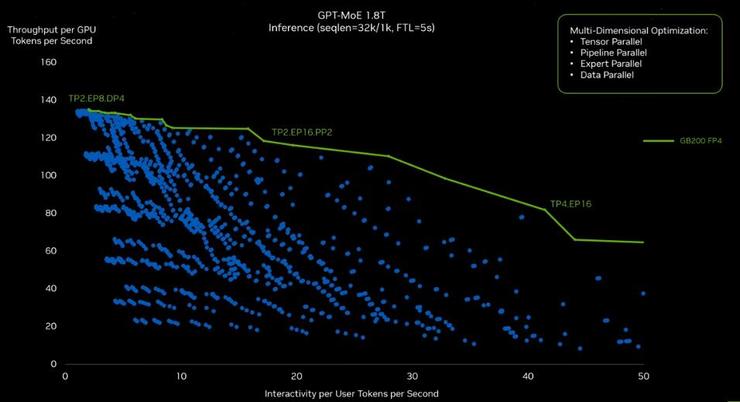

Blackwell 能大幅提高大模型的训练、推理效率。 在 FP8 训练方面,Blackwell 的每芯片性能是其前身的 2.5 倍,在 FP4 推理方面的性能是其前身的 5 倍。它具有第五代 NVLink 互连,速度是 Hopper 的两倍,并且可扩展至 576 个 GPU。

黄仁勋以训练 1.8 万亿参数 GPT 模型的资源消耗为例,直观地展现了 Backwell 作为 “一个巨型 GPU” 的强大之处:使用 Hopper GPU,需 8000 张,耗能 15 兆瓦,耗时 90 天;而 Blackwell GPU 仅需 2000 张,电力消耗减少 75%,同样 90 天内完成。

为了扩大 Blackwell 的规模,英伟达还构建了一款名为 NVLink Switch 的新芯片。每个 Blackwell 芯片能以每秒 1.8 TB 的速度与四个 NVLink 互连,并通过减少网络内流量来消除流量。

此外,GB200 芯片的设计将两个 B200 Blackwell GPU 与一款基于 Arm 架构的 Grace CPU 相结合,旨在提供更加强大的计算能力和更高的效率。这种配对设计不仅增强了处理能力,也为 AI 大模型的运行提供了更为优化的平台。

正如黄仁勋所说的一样,“整个行业都在为 Blackwell 做准备”,目前 Blackwell 正在被全球各大云服务提供商、AI 公司和电信公司等采用。

在 GTC 大会上,微软和英伟达深化了双方长期以来的合作关系,整合了英伟达生成式人工智能和 Omniverse 技术,这些技术已广泛应用至微软 Azure、Azure AI 服务、微软 Fabric 以及微软 365 等平台。

微软 CEO 萨提亚·纳德拉表示:“与英伟达携手合作,我们正在将人工智能的潜力变为现实,助力全球各地的人们和组织实现新的效益和生产力提升。

从将 GB200 Grace Blackwell 处理器引入 Azure,到 DGX Cloud 与微软 Fabric 之间的新集成,我们今天宣布的一系列举措将确保客户能够在 Copilot 堆栈的每一层面上,从硅芯片到软件,都能拥有最全面的平台和工具,以构建自己的突破性 AI 能力。”

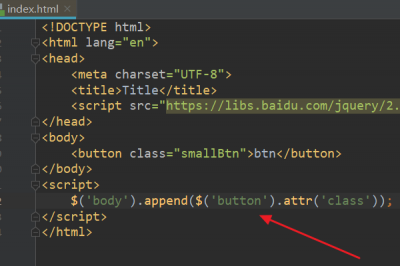

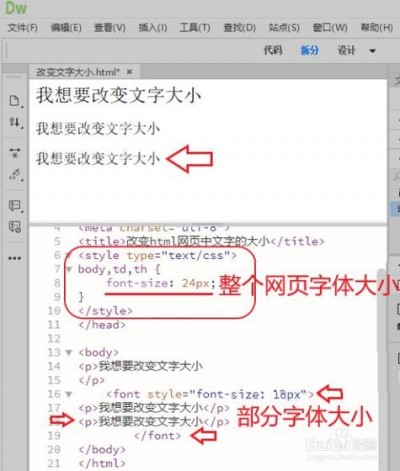

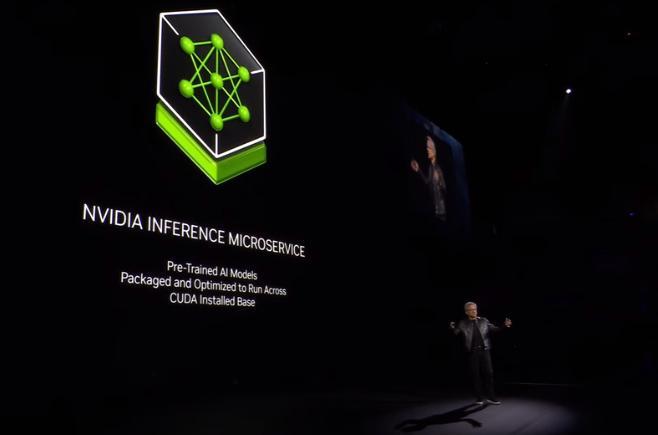

除了“GB200”这位绝对主角外,黄仁勋也在 GTC 大会上官宣了英伟达在软件开发的革新“NVIDIA NIM”。他表示,未来构建软件时不太可能从头开始编写或编写一大堆 Python 代码之类的东西,“很可能你会组建一支 AI 团队。”

NVIDIA NIM 由英伟达的加速计算库和生成式 AI 模型构建,支持行业标准 API,因此易于连接,可在英伟达庞大的 CUDA 安装基础上工作,针对新 GPU 进行重新优化,并不断扫描安全漏洞和漏洞,目前 Cohesity、NetApp 和 Snowflake 等科技公司已在使用。

在 GTC 大会上,黄仁勋还宣布了与众多公司的合作。

在半导体制造行业,英伟达已与台积电和 Synopsys 合作,将其计算光刻平台 CuLitho 应用于先进芯片的生产过程。

在电信行业,推出 NVIDIA 6G 研究云,这是由生成式人工智能和 Omniverse 技术提供动力的平台,致力于推进下一代通信技术的进步。

在在交通运输行业,比亚迪计划利用英伟达的集中式车载计算平台 DRIVE Thor 来开发其下一代电动车型。

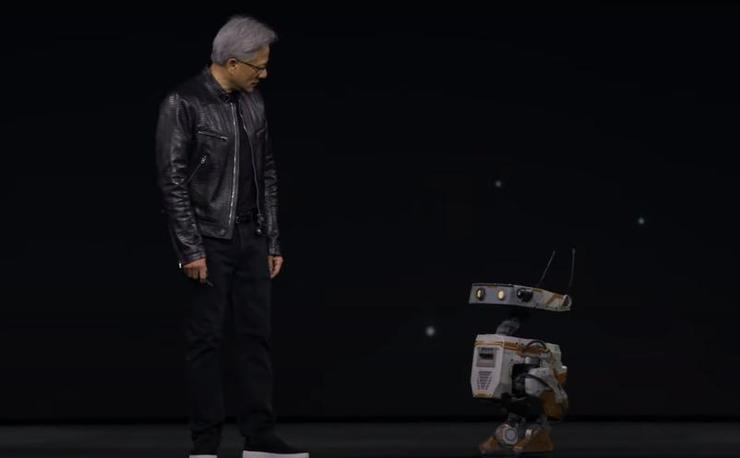

此外,黄仁勋还宣布了一系列旨在推动英伟达机器人技术研发的项目,如机械臂感知、路径规划和运动学控制库 Isaac Manipulator,人形机器人的模型平台 GR00T,和新型计算机 Jetson Thor。

最后,搭载了英伟达为机器人设计的首款 AI 芯片 Jetson 的迪士尼机器人 orange 和 green 也登上了舞台,陪伴黄仁勋为演讲画上了句号。

AI 芯片新皇登场的后续思考

We need Bigger GPUs… A very very big GPU!

非常非常大的 GPU,是老黄对于整场 GTC 大会最切实的表达。毕竟,新 Blackwell 架构 GPU 组成的 GB200,将提供 4 倍于 Hopper 的训练性能,大模型参数达到了万亿级别。

另一方面,为了更好地服务于日益壮大的大模型应用领域,英伟达推出了极具针对性的服务——模型定制服务 Nvidia Inference Manager(简称 NIM),这意味着只要有英伟达硬件的存在,用户就能便捷地进行大模型的调试与应用。

看得出来,老黄对于大力出奇迹这一理论也持认可态度。

而大众对于这一消息的第一反应则大部分是震惊,甚至用了感到炸裂来形容。通过英伟达的种种做法,我们也不禁感慨,英伟达在 AI 行业的地位已有目共睹。

甚至有业内人士用了 AI 时代的思科以及 AI 时代的 Wintel 来形容。(思科在网络设备和协议标准化方面曾起到了至关重要的作用,而英伟达通过其 GPU 和 AI 平台推动了 AI 计算基础设施的发展,为数据中心、云端和边缘计算提供了关键的硬件支持。)

在炸裂之后,我们可以看到,英伟达 GB200 的发布对于行业的技术突破和商业发展都带来了深远的影响。

在技术上,业界一致认为通过不断挖掘和利用高性能计算的力量,来拓展人工智能技术的规模化疆界,是推动行业发展的重要手段。

国家超级计算深圳中心主任冯圣中在评价英伟达 GB200 的卓越表现时,则用“进步显著,但仍有巨大潜力可挖”进行了精辟总结。这也意味着 GB200 乃至整个高性能计算与 AI 领域,未来都还还可能在技术上有更为突破性的表现出现。

不过除了对 GTC 所展现出来的对技术强烈认可和憧憬之外,更多行业人士关注的则是 GB200 发布对于商业和国内整体市场的影响。

在芯片领域,产能和定价是最为被大家关注的问题。一位资深投资者向笔者指出,GB200 的发布是技术上的突破,但如果产能能放量的话,则会更加成为商业上的炸裂。

目前整体而言,大模型的成本还是太贵。拿大家熟知百度文心为例,业内消息指出文心大模型 4.0 的推理成本相比于之前的版本出现了大幅增长,最高据说增加了8-10 倍,这意味着提供实时生成内容服务的成本骤增。这意味 GB200 的成本一旦打下来,国内芯片厂商的空间会被挤压得更加厉害。

而在整个 GTC 大会上,我们发现,不同于以往的发布单一芯片,这次英伟达直接放出整个服务器。也引发了对于市场格局的思考。国内某大型元器件公司从业者告诉 AI 科技评论,英伟达的做法很明显,自身在底层东西很强势,就干脆直接不做单套,直接卖整机,反正最后都得垄断。

下放到中国市场,大家的一致看法则是,按照以往美国的做法,大概率产品一经发行便会受到制裁。业内投资人告诉 AI 科技评论,新一波的制裁大概率会出现在四月份。

这意味着,在国内先进制程中短期内(5 年)或都难以赶上国外的现状之下,H800 等被阉割系列的存量运营效率价值将显著提升,水货和渠道货的价格可能会迎来回弹和普涨,这其实也将进一步加剧供应链紧张态势。

在此背景下,大模型厂商如何合法合理地借鉴云服务提供商的经验,寻求海外采购及储备策略,成为一个具有实际意义的研究课题。

另一方面,稳扎稳打投资 Infra 公司、把生态+推理的量提升或许也更加具有借鉴意义。

正如搭建高楼大厦,追求最顶尖的建筑材料和技术固然重要,但这并不意味着所有建设项目都将仅仅依赖于最先进的顶层设计,其余基础材料也同样至关重要。这也就意味着即使在高端产品领域我们暂时未能赶超,但在 AI 在基础建设层面孕育大量的市场需求和发展机遇。

而对于国内 GPU 厂商而言,套用某 GPU 从业者的话则是:英伟达牛逼惯了,大概率会被制裁,国内的 GPU 公司则更加要好做产品,从能卖掉的做起来。